Шардинг В Блокчейне: Что Это И Как Он Работает?

В этом случае положительные гошные числа могут превратиться в отрицательные постгревые, поэтому делаем NOT IN для ренджа. Очень удобно шардировать в приложении, где еще нет данных, а следовательно нет необходимости их перетаскивать. Ну и инфраструктурная обёрточка — чтобы запросы выполнялись параллельно. Кажется, что он довольно большой, но в действительности большую часть метода съедают раскручивания каналов. Давайте в качестве примера сделаем клиентское шардирование горячо любимой в Ozon PostgreSQL. Для начала нам надо добавить сами шарды, то есть развернуть еще одну инсталляцию БД.

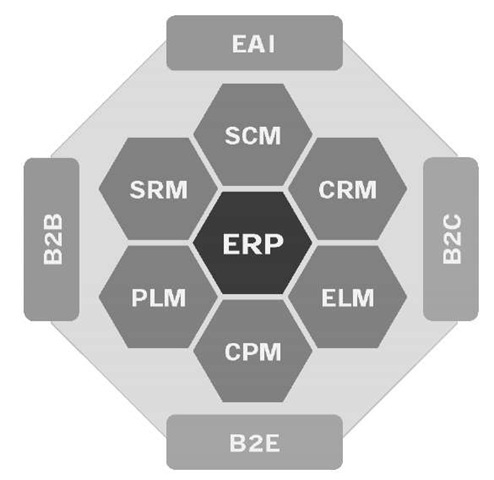

Например, шардирование по дате создания для данных о событиях приведет к тому, что все новые данные будут писаться в один шард, создавая чудовищную нагрузку. Мы используем комбинированные ключи (например, user_id + timestamp) и хеш-функции для обеспечения равномерности. Когда мощности одного сервера (как бы вы его ни оптимизировали) уже недостаточно, наступает время шардирования. Шардирование — это распределение данных между несколькими независимыми серверами (шардами), каждый из которых отвечает за свой сегмент данных. В отличие от партиционирования, управление шардированием часто ложится на плечи приложения или специального промежуточного ПО (middleware).

Партиционирование Vs Шардирование: Что И Когда Выбирать?

Каждый из них работает как мини-блокчейн, имея собственные узлы, обработку транзакций и смарт-контракты. Вместо того чтобы шард проверял все операции в сети, он отвечает только за определенную часть данных, что значительно ускоряет обработку. Шардирование — это принцип проектирования базы данных, при котором части https://www.xcritical.com/ одной таблицы размещаются на разных шардах. Шард — узел кластера, который может состоять из одной или нескольких реплик.

Атаки На Отдельные Шарды (shard Takeover Attack)

Во-вторых, это отсутствие стратегии управления жизненным циклом данных. Мы внедряем автоматизированные скрипты и процедуры, которые берут на себя всю рутину по управлению партициями. Для работы транзакций физический слой должен вести журнал, аналогичный Write-Ahead Log (WAL) в PostgreSQL. Теоретически его можно было бы использовать для репликации, но логический слой не имеет доступа к физическому слою напрямую.

По сути, это тот же горизонтальный sharding с разбиением данных на кусочки по строкам при помощи диапазонов. Чтобы приложение могло понять, в какой шард отправить запрос, нужна особая архитектура. Речь о практически полной копии sortItemsIDsByShard; разница лишь в том, что для получения идентификатора шарда мы используем ранее модифицированную функцию. Можно просто скопировать данные в другой шард, а потом просто удалить их из источника, но на практике я такого не встречал.

Нужно добавлять новые шарды при росте данных, перебалансировать данные между шардами, следить за их состоянием. Мы предлагаем готовые решения и практики для автоматизации управления кластером, что значительно снижает операционные риски и затраты. Вертикальное шардирование — менее распространенный, но крайне полезный в определенных сценариях подход. Отставание реплики (или лаг репликации) возникает, когда изменения, внесённые на master-сервере, не успевают вовремя применяться на репликах. Это может привести к несогласованности данных между grasp и репликами, что особенно затрудняет выполнение операций, требующих актуальных данных.

Это полезно, когда у таблицы очень много столбцов или когда группы столбцов имеют совершенно разные паттерны доступа. Мы можем улучшить производительность запросов, так как они работают с таблицами как получить Форекс лицензию меньшей ширины. Благодаря этому способу мы можем равномерно распределять данные, и нам будет проще масштабировать систему при помощи создания новых шадров и добавления серверов. Благодаря такой архитектуре мы можем «скрыть» database sharding на стороне клиента и обеспечить централизованное управление запросами. Не надо сильно заморачиваться с кодом и архитектурой приложений, ведь вся логика будет на серверах. Главная цель такого разделения — добиться независимости шардов.

Можно рассмотреть более сложный случай, если место в кеше ограниченно, то его можно либо зачистить полностью, либо зачистить виртуальные сегменты, которые будут переноситься. А ещё бывают исключения, например люди – которые заказывают в 100 раз больше, чем обычные или популярные новостные каналы, или очень крупные поставщики с x100 товаров. Актор направляет свою команду в маршрутизатор, который по определённому правилу выбирает сегмент для обработки и отправляет команду в этот сегмент. Иногда команда уходит в несколько сегментов, и на маршрутизаторе происходит агрегация полученного результата.

Шардированный кластер — это распределённая система, управлять которой сложнее, чем одним сервером. Vitess вместо прямых команд для шардинга определяет его правила в отдельном JSON-файле, который называется VSchema (Vitess Schema). Горизонтальный sharding — идеальный вариант, когда основная проблема — это огромное количество строк в таблицах и высокая нагрузка на чтение/запись.

Шардинг в блокчейне можно реализовать разными способами, в зависимости от того, какие компоненты сети разделяются между шардами. Для плавного решардинга, без перерыва в работе вам придётся организовать оркестратор, который будет производить блокировку и разблокировку, а также добавлять признак того, что запись в процессе миграции. Решардинг или пересегментирование – процесс, который переносит данные из одного сегмент в другой. Необходимость в процессе возникает при смене правила сегментирования, когда текущее хранение информации не соответствует желаемому. В карте можно хранить не конкретный сегмент, а виртуальный сегмент (фактически аналог результата хеш-функции), и автоматизировать их заполнение можно через хеш-функцию. А для особых случаев сделать значения вне диапазона хеш-функции.

- Асинхронная репликация — это метод репликации, при котором изменения сначала записываются на master-сервер, а затем с некоторой задержкой пересылаются на slave-реплики.

- Это значит, что каждый сервер хранит только свою уникальную часть информации.

- Для отправки сообщений добавлен новый интерфейс ShardedEventProducer, позволяющий указать в какой именно шард нужно отправлять сообщение.

- Шардирование – это мощный, но непростой способ заставить вашу систему справляться с огромными объемами данных и нагрузок.

- Однако, этот метод по-прежнему ограничивается ресурсами одного сервера и не повышает отказоустойчивость системы в целом, т.к.

Данные делятся на чанки (кусочки), которые распределяются по шардам на основе шард-ключа. Это поле (или набор полей), по которому MongoDB решает, куда класть документ. Выбор шард-ключа — это отдельная магия, и тут шардирование это можно как взлететь, так и знатно облажаться (об этом ниже).

“Фарш невозможно провернуть назад”, при радикальной смене хеш-функции глобальный решардинг неизбежен. Предположим, у нас есть идентификатор у каждой записи, по которому мы хотим распределить записи между сегментами. Это может быть ИД записи, а может быть поле для группировки, например, ид пользователя для заказов. Давайте рассмотрим, один из способов разбиения более подробно.